Objectives

- Explain the key elements of recurrent networks

- Design and implement recurrent networks

Tutorial

- Recurrent network

- Backpropagation through RNN

이 다원은 RNN을 통째로 다룬만큼 RNN의 역할이 굉장히 크다는 것을 알려준다.

!핵심 정리!

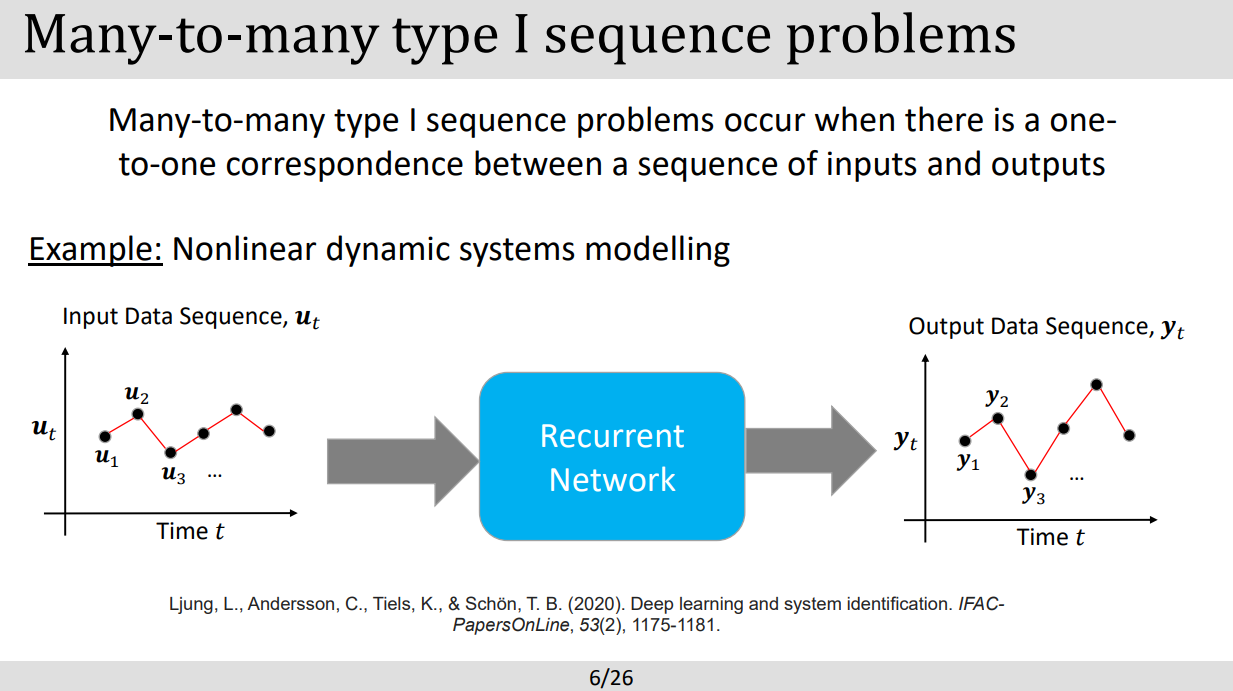

- RNN 은 sequential data을 프로세싱하기위해 사용되며 사용되는곳은 자연어 처리나 음석인식같이 데이터들이 시간적순서의 연관성을 가진곳에 사용되는 딥러닝방식이다.

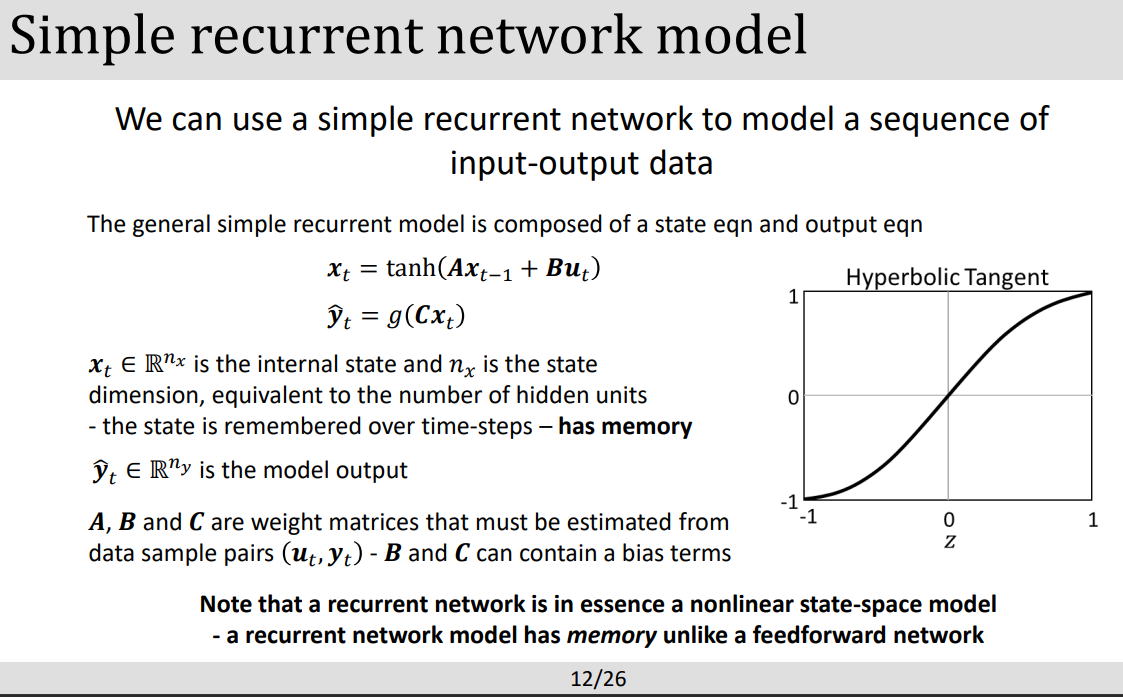

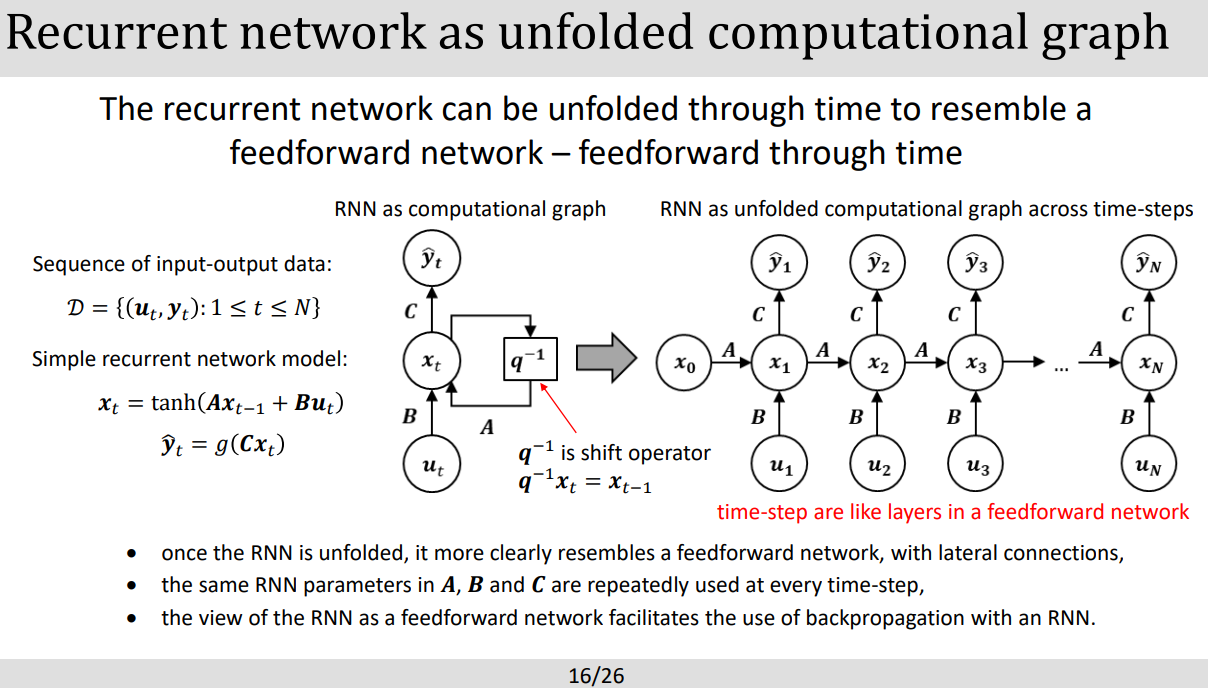

- RNN의 구조의 특징은 Feedforward와는 다르게 memory 가 존재하는데 이는 그이전 스텝의 정보를 보관하므로써 현재 스텝의 정보와 결합 시킬 수 있다.

- RNN의 핵심 개념하나는 Recurrent(되풀이되는) connection 인데 이로써 정보들이 스텝간에 이동할 수 있게 해준다. 좀더 자세히 설명하면 현재 스텝에서 그이전에서 발신된 hidden state 가 있는데 이는 메모리역활차럼 context 정보를 가지고있어 현재 스텝에서 그이전 정보들을 사용할 수 있다. 이로써 자연어처리때 다음 단어가 어떤 단어가 올지, 미래에 어떤 값이 들어올지 예측할 수 있다.

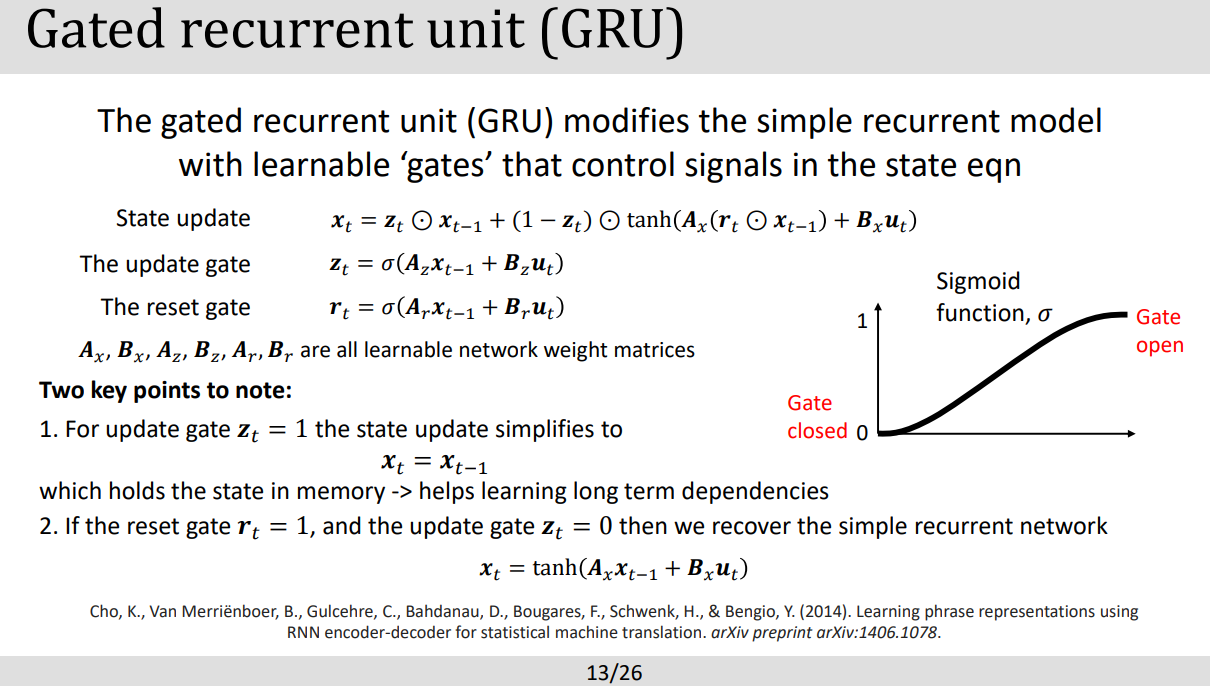

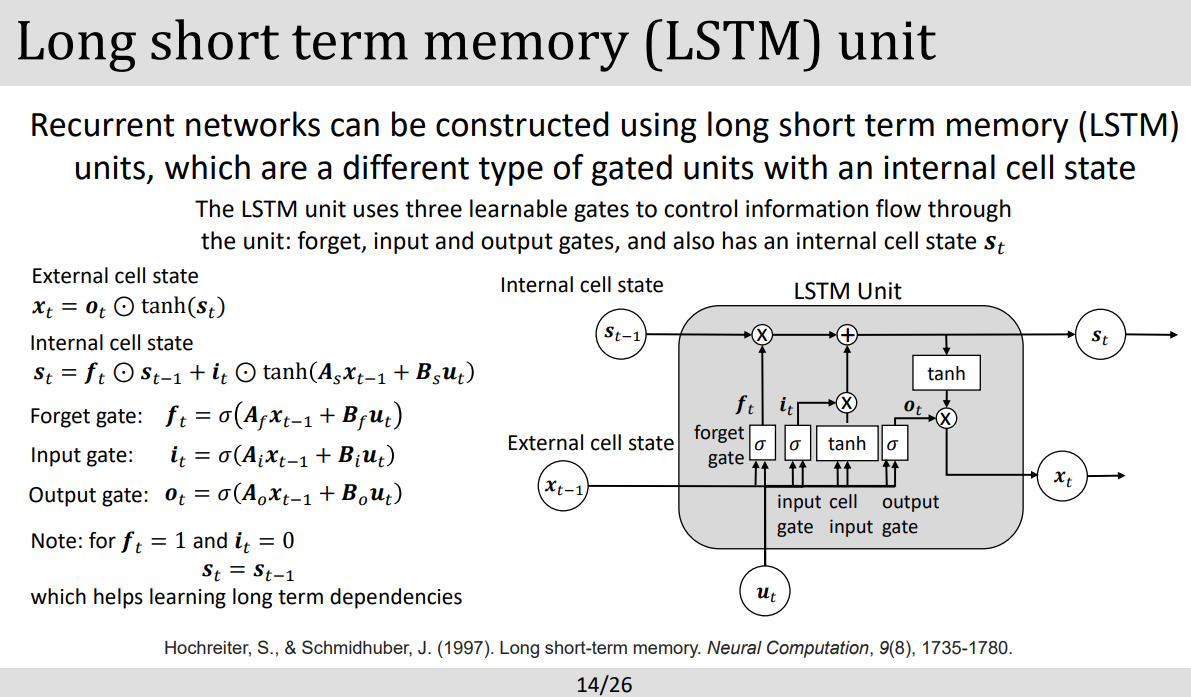

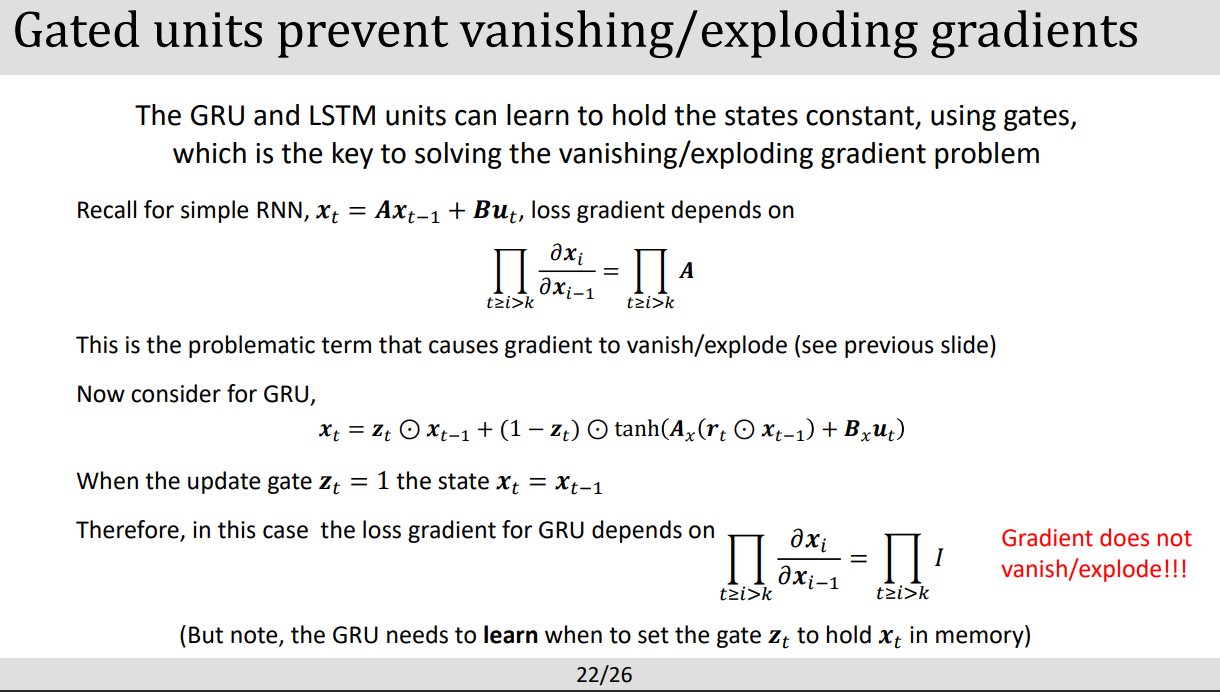

- RNN의 단점으로는 Vanishing gradient 와 exploding gradient 가 있는데 이를 해결하기위해 Long-Term Memory(LSTM) 과 Gated Recurrent Unit(GRU)가 개발되었다.

PART1: SEQUENCE DATA

PART2: RECURRENT NETWORK MODELS

- 튜토리얼 출제됨 . 각 파라미터가 무엇을 뜻하는지.

- RNN 은 Nonlinear state-space model 에 필수적며 RN Model 은 memory를 가지고있다

PART3: TRAINING RECURRENT NETWORK MODELS

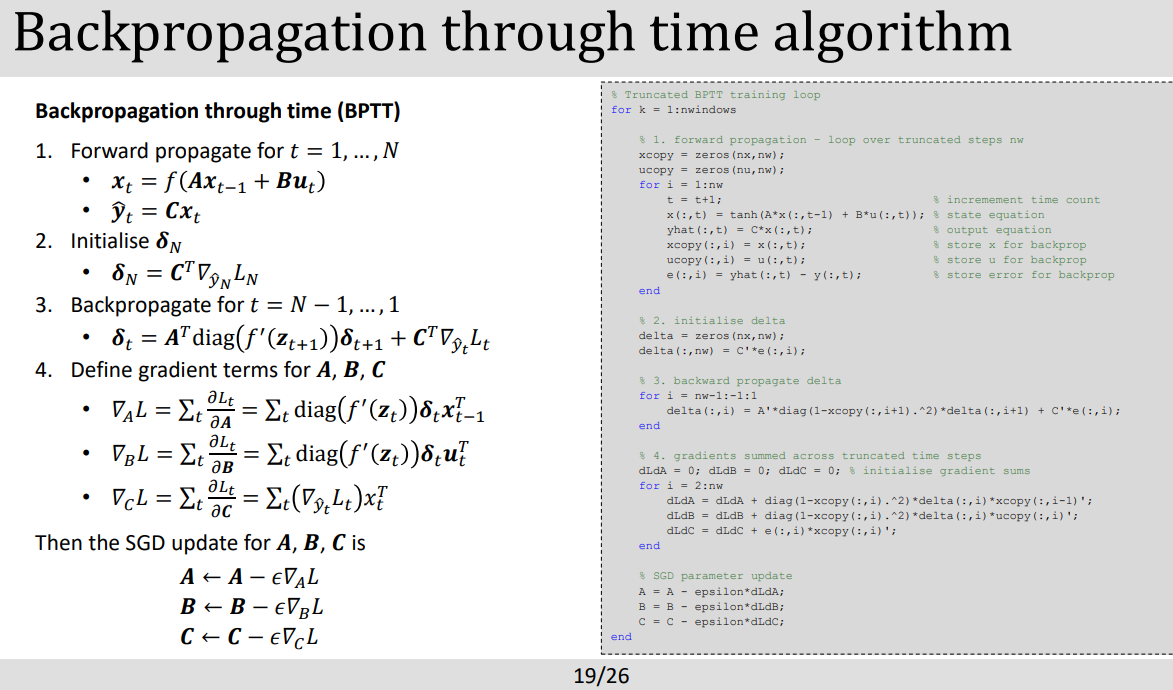

- Truncated (잘라낸) backpropagation through time 으로 vanishing gradient problem을 잡는다. 이는 즉 전체의 시간을 중간중간 잘라내어 프로세싱하게한다.

- gradient cliping 으로 gradient explosion을 잡아낼수있다고한다. gradient가 너무 크면 폭발되버릴수 있는데 이에 threshold를 걸어 gradient cliping이 이르 Euclidean norm(L2 norm)이나 sum of absolute value(L1 norm)으로 계산시키는 원리이다.

- 튜토리얼 출제!!!

- 나올거같은데

'[End]Robotics Lectures in UoS > Deep Learning' 카테고리의 다른 글

| [DL] Lecture11: Intro to Reinforment Learning (0) | 2023.05.24 |

|---|---|

| [DL] Lecture8: Natural Language Processing (0) | 2023.05.07 |

| [DL] Lecture6:Deep learning for computer vision (0) | 2023.05.06 |

| [DL] Lecture5: Convolutional Networks (0) | 2023.05.05 |

| [DL] lecture4: Optimization and Regularization Techniques (0) | 2023.05.05 |

댓글